Страницы с get параметрами seo

Структура URL

При ранжировании поисковые системы стараются использовать максимум полезной информации, которую могут извлечь из:

И на анализе URL-адреса страницы также основывается ряд факторов. Общие пожелания к URL-адресам продвигаемых страниц следующие:

Если рассматривать ситуацию, описанную вами, то наличие ключевых слов из потенциальных целевых запросов встречается и в первом (/zhenskiye-bryuki/filter?tsvet= belyy&razmer= 46) и во втором (/zhenskiye-bryuki/filter/ belyy/razmer- 46) случае, так что тут нет проблем. Поисковые системы (и тем более Яндекс и Google), без каких либо трудностей, индексирует страницы с GET-параметрами, так что тут тоже не наблюдается проблемы.

Потенциальные трудности страниц с GET-параметрами

Но существует ряд негативных моментов при работе со страницами с наличием GET-параметров (/filter?tsvet=belyy&razmer=46 и т.д.), это:

Прочие работы по SEO

При этом, абсолютно нет никаких проблем в том, чтобы реализовать возможность добавления уникального заголовка Title, текста, текстовых заголовков, meta-данных и другого контента на динамических страницах с GET-параметрами. Для полноценной оптимизации данных полей создавать статические страницы не требуется.

Это самые основные работы по внутренней оптимизации и ими и требуется заняться на текущем этапе работ в рамках SEO.

В сухом остатке

Если резюмировать сказанное ваше и наш опыт в сфере продвижения сайтов, то можно сказать, что совет от SEO-компании по корректировке адресов страниц является разумным, хотя ряд доводов в пользу этого не имеют отношения к реальности. Также, если реализовывать новую систему ЧПУ, то от слова «filter» в адресе лучше совсем отказаться, оно не несет ничего положительного ни для SEO, ни для пользователя, а лишь удлиняет адрес.

Оптимальный URL-адрес мы бы обозначили как такой: /zhenskiye-bryuki/belye/46/.

Выигрыш после внедрения новой системы URL и простановки 301-редиректов можно оценить в рамках 0,5-1,5 позиции в выдаче.

Удачи в проведении работ по оптимизации URL-структуры вашего сайта!

Ошибка Я. Вебмастера: найдены страницы дубли с GET-параметрами — что делать

Дубли страниц могут приводить к потери позиций в поисковой выдаче и снижать скорость индексации. Стоит понимать, что у поискового робота есть определенный лимит запросов к домену в день. Поэтому существует вероятность того, что он потратит все лимиты на сканирование мусорных страниц и не доберется до страниц с уникальным контентом.

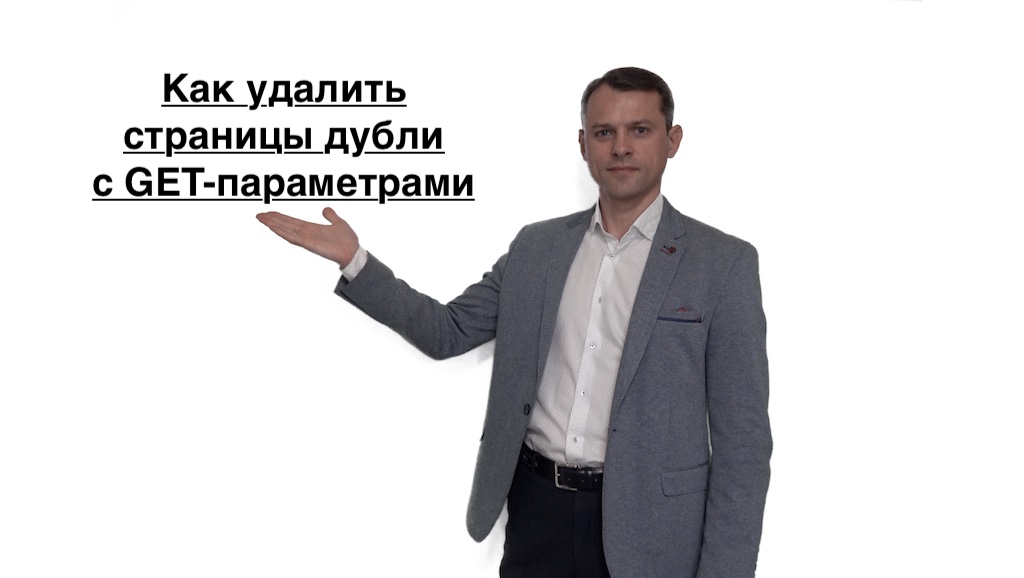

О наличии проблемы с дублированным контентом свидетельствует сообщение в панели Вебмастера: «Найдены страницы дубли с GET параметрами». В своем сообщении Яндекс информирует вебмастера о том, что на некоторых страницах сайта размещен одинаковый контент, различающийся только гет-параметрами.

Что такое get-параметры на сайте

Если в поиске есть дублированные страницы из-за гет-параметров, Яндекс предлагает воспользоваться правилом Clean-param в robots.txt (правило действительно только для Яндекс, Google его не воспринимает).

В результате использования Clean-param поисковый робот Яндекса объединяет сигналы с дублированных страниц на основной. После того, как краулер узнает обо всех произошедших изменениях, страницы с не имеющими значение гет-параметрами исчезнут из поисковой выдачи.

Как использовать Clean-param

Для понимания того, как используется Clean-param, стоит привести простой пример. Существуют дубли страницы со следующими гет-параметрами:

Чтобы в результатах поиска учитывалась только основная страница http://mysite.ru/cat/auto/nissan/, нужно задать правило Clean-param в файле robots.txt:

User-agent: Yandex

Clean-param: sort&order /cat/auto/nissan/

Как использовать Disallow

Избавиться от страниц-дублей с GET-параметрами можно, используя директиву Disallow. Для примера возьмем те же страницы-дубли:

Чтобы в результатах поиска учитывалась только основная страница http://mysite.ru/cat/auto/nissan/, нужно задать правило в файле robots.txt:

User-agent: *

Disallow: *?sort=

Disallow: *&order=

Также можно закрыть от индексации ВСЕ Get-параметры одним правилом?

User-agent: *

Disallow: *?

Будьте осторожны! Используйте директиву Disallow очень внимательно, чтобы случайно не закрыть от индексации нужные страницы (например, не используйте правило, если карточки товара или категории в обязательном порядке содержат get-параметр в url).

Найдены страницы-дубли с GET-параметрами

Нет времени читать статью?

Но вам требуется продвижение сайта или создание сайта-лидера, идеального для SEO? Тогда вы можете оставить заявку на продвижение или заявку на создание сайта. Если вы собираетесь продвигать сайт самостоятельно — продолжайте чтение!

У сайта появились дубли страниц, которые мешают ему продвигать и создают проблемы: идет снижение индексации, ранжирования. Каждый день поисковая система индексирует определенный сайт и у него есть свой лимит к домену в сутки. Когда все лимиты уходят на мусорные страницы и URL, становится обидно, потому что качественные страницы с уникальным контентом остались в стороне.

Как узнать есть ли дубли на сайте? Например, в вебмастере Яндекс появилось сообщение: «Найдены страницы дубли с GET параметрами». Это значит, что поисковая система передает информацию владельцам сайтам, что контент есть на разных страница, а он одинаковый везде.

Что такое get-параметры на сайте

GET параметры в URL — специальные динамические параметры, которые позволяют изменять контент на страницах сайта. Часто находится в URL адресе сразу же после «?» и может разделяться «&». Часто владельцы сайтов интернет магазинов используют GET запросы и параметры для фильтров на сайте, либо для сортировки.

Как избавиться от ошибки — Найдены страницы дубли с GET-параметрами

Простой и рабочий способ избавиться сейчас от таких дублей внести правки в ваш файл Robots.txt, через директорию и правила Clean-param или Disallow.

Если вы видите, что у вас появились дубли (дублированные страницы) из-за GET параметров, то Яндекс предлагает сделать вам правило Clean-param, которое будет действовать именно для Яше.

Это позволит поисковому роботу понять и объединить страницы, которые являются дублями. Если произошли изменения, тогда бот сможет их проверить и убрать лишний мусор из поиска.

Как использовать Clean-param

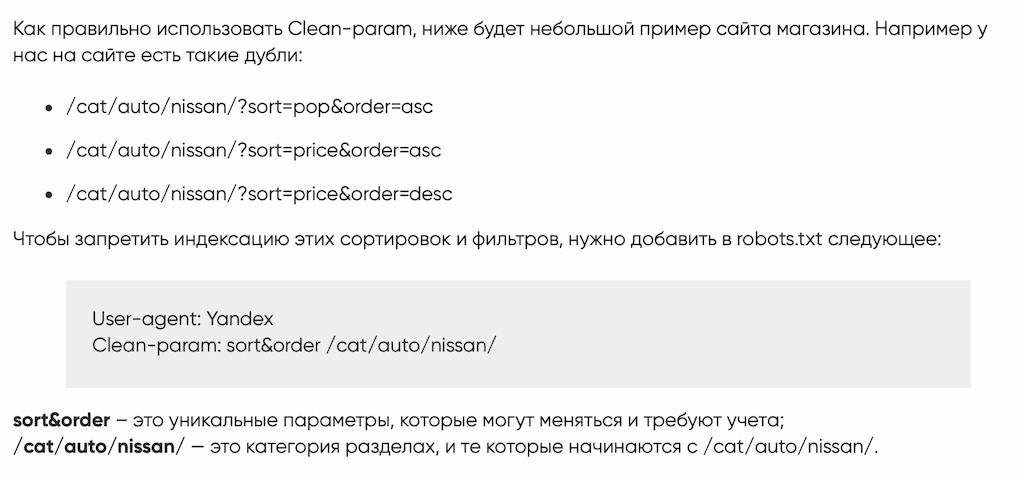

Как правильно использовать Clean-param, ниже будет небольшой пример сайта магазина. Например у нас на сайте есть такие дубли:

Чтобы запретить индексацию этих сортировок и фильтров, нужно добавить в robots.txt следующее:

User-agent: Yandex

Clean-param: sort&order /cat/auto/nissan/

sort&order – это уникальные параметры, которые могут меняться и требуют учета;

/cat/auto/nissan/ — это категория разделах, и те которые начинаются с /cat/auto/nissan/.

Как использовать Disallow

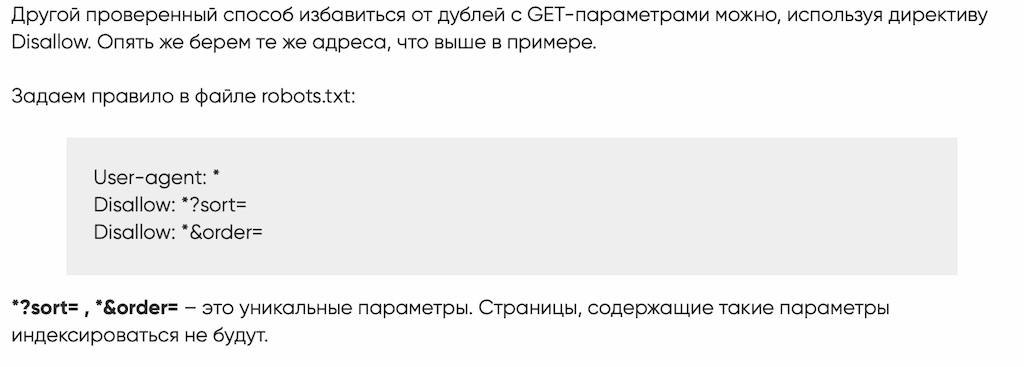

Другой проверенный способ избавиться от дублей с GET-параметрами можно, используя директиву Disallow. Опять же берем те же адреса, что выше в примере.

Задаем правило в файле robots.txt:

Как полностью закрыть все параметры GET одной строкой?

Однако нужно понимать, что если вы полностью закроете все страницы от индексации, иногда есть специальные страницы, которые могут быть обязательны.

Однако способами выше вы сможете решить проблему в Вебмастере Яндексе, гугле.

Найдены страницы дубли с GET-параметрами | Что это такое и что с ними делать

Добрейшего всем денечка! С вами Кузнецов Анатолий и сегодня я затрону очень важную тему и боль интернет-магазинов, на которых в вебмастере Яндекс высветилась надпись: “найдены страницы дубли с GET-параметрами“. Эти дубли действительно сильно портят жизнь сайтам и ухудшают их ранжирование в поисковой системе Яндекс.

Чем опасны страницы дубли с GET-параметрами для SEO

Любые возникающие дубли страниц на сайте могут попасть в индекс вместо главных (рабочих и продающих) страниц, а также замедлить обход и индексацию роботами скроллерами. Если объяснять по простому, то дубли страниц – это практически полностью похожие друг на друга страницы сайта с одинаковым содержимым. Когда поисковые роботы видят такие дубли, они не могут понять, какая страница наиболее релевантна и могут исключить из индекса обе, либо проиндексировать не ту которая нужна вам. Это и является основной болью.

Страницы с GET-параметрами влияющие на содержание не являются дублями. А если в свою очередь GET параметр не изменяет контент (URL) на конкретной странице, то он является дублирующим и его необходимо скрыть от индексации поисковыми роботами.

Что такое страницы дубли с GET-параметрами

GET-параметр — это параметр, который передается серверу в URL страницы. Он начинается с вопросительного знака. Если URL содержит более одного параметра, то эти параметры разделяются знаком «&». Самый частый случай появления дублей из-за незначащих параметров — метки для задач веб-аналитики. Например, utm_source, utm_medium, from. Такими метками владельцы сайтов привыкли помечать трафик. Фактически эти URL одинаковые, на них опубликован одинаковый контент. Но формально адреса разные, так как различаются GET-параметрами в URL. Соответственно, и поиск тоже может посчитать их разными. Такие страницы и называются дублями с незначащими GET-параметрами.

Зачем нужно постоянно отслеживать страницы дубли с GET-параметрами

Как удалить страницы дубли с GET-параметрами

Самый простой и рабочий метод удаления дублей страниц, это внести изменения в файл Robots.txt, через директорию и правила Clean-param или Disallow. Собственно это предлагает сделать и сам Яндекс в Вебмастере:

Что такое деректива clean-param

Как использовать Clean-param

Если у вас нет позможности добавить на сайт дерективу Clean-param, то необходимо прописать для каждой дублированной страницы канонические параметры. Но этот метод не уменьшит нагрузку на сайт, так как роботы Яндекса будут обрашаться к команде rel=canonical и обходить страницы дублей.

Если оба способа вам не подходят, то можно жестко перекрыть доступ роботам к таким страницам, выключив их из индекса дерективой Disallow. В таком случае поисковик не будет получать никаких сигналов от этих страниц.

Как использовать директиву Disallow

Бесплатная проверка сайта на SEO ошибки

Специально для читателей моего блога я разработал бесплатный сервис проверки сайта на наличие технических и SEO ошибок, которые сдерживают его продвижение в поисковых системах Яндекс и Google. Устранив эти проблемы, ваш сайт вздохнет полной грудью и оставит конкурентов позади! Посмотрите короткое видео о работе сервиса и проверяйте свой WEB ресурс:

Заключение

Вы получили печальный опыт блокировки за накрутку, испробовали уже все методы продвижения, а толку нет? Разочаровались в Яндекс Директ и Google Adwords. Пора прекращать верить в сказки и доброго волшебника в голубом вертолете, который спасёт ваш бизнес. Пора заняться действительно качественной и проверенной временем SEO работой – начать продвижение интернет магазина или сайта статьями! Не хочу вас уговаривать, да если честно и смысла нет, так как очередь на продвижение у меня уже растянулась минимум на три месяца вперед (подробнее мои SEO кейсы). Я информирую Вас лишь для того, чтобы Вы впервые выбрали для себя правильный путь развития бизнеса и наконец-то получили результат. И не важно, я буду в этом вам помогать или Дядя Ваня. Но все же, если Вы хотите выбрать меня, то жмите кнопку ниже (пишите, звоните) и мы скорее всего договоримся и я спустя какое-то время возьмусь за ваш WEB проект и вдохну в него жизнь в виде действительно продающих текстов!

Как найти дубли страниц с незначащими GET-параметрами

Дубли страниц на сайте могут появиться в поиске вместо ценных страниц сайта или замедлить их обход и индексирование.

Вообще, дубли — это страницы сайта, содержание текста в которых полностью или практически совпадает. Страницы с GET-параметрами в URL тоже могут быть дублями. Если GET-параметр влияет на содержание страницы — это не дубль. А если GET-параметр не меняет контент страницы, то этот параметр называют незначащим и страницу стоит скрыть от поиска.

Расскажем подробнее, что такое незначащие GET-параметры, как найти дубли с такими параметрами и убрать их.

Что такое дубли страниц с незначащими GET-параметрами

GET-параметр — это параметр, который передается серверу в URL страницы. Он начинается с вопросительного знака. Если URL содержит более одного параметра, то эти параметры разделяются знаком «&». Самый частый случай появления дублей из-за незначащих параметров — метки для задач веб-аналитики. Например, utm_source, utm_medium, from. Такими метками владельцы сайтов привыкли помечать трафик. Фактически эти URL одинаковые, на них опубликован одинаковый контент. Но формально адреса разные, так как различаются GET-параметрами в URL. Соответственно, и поиск тоже может посчитать их разными. Такие страницы и называются дублями с незначащими GET-параметрами.

Наличие дублей страниц с незначащими GET-параметрами не приносит пользы и может негативно сказаться на взаимодействии сайта с поисковой системой.

Зачем отслеживать дубли

1) Скорость обхода. Когда на сайте много дублей, роботы тратят больше времени и ресурсов на их обход, вместо того, чтобы обходить ценный контент. А значит, ценные страницы вашего сайта будут медленнее попадать в поиск.

2) Неуправляемость. Так как поисковой робот произвольно выбирает, какой из дублей показывать в поиске, то на поиск могут попасть не те страницы, которые вам нужны.

3) Влияние на поиск. Если незначащие параметры не добавлены в clean-param, робот может обходить эти страницы и считать их разными, не объединяя их в поиске. Тогда поисковый робот будет получать разные неагрегируемые сигналы по каждой из них. Если бы все сигналы получала одна страница, то она имела бы шансы показываться выше в поиске.

4) Нагрузка на сайт. Лишний обход роботом также дает нагрузку на сайт.

Например, на сайте по продаже билетов есть форма заявки на обратный звонок. При ее заполнении в url передается GET-параметр?form=show1, — он сообщает информацию о том, какой спектакль с этой страницы выбрал пользователь в заявке, хотя контент самой страницы никак не меняется. Таким образом, поисковой робот будет тратить время на обход множества одинаковых страниц, различающихся только GET-параметрами в URL, а до ценных страниц сайта доберется значительно позже.

Для интернет-магазинов типичный пример — страницы с фильтрами. Например, если пользователь выбирает товары в дорогом ценовом диапазоне, изменяя значения в фильтре «Цена», то в большинстве случаев ему будет показана страница с одними и теми же товарами. Таким образом, поиск будет получать сигналы о множестве одинаковых страниц, отличающихся только GET-параметром price= в URL.

Как обнаружить дубли

Теперь находить одинаковые страницы стало проще: в разделе «Диагностика» появилось специальное уведомление, которое расскажет про дубли из-за GET-параметров. Алерт появляется с небольшой задержкой в 2-3 дня, поэтому если вы увидели в нем исправленные страницы, не пугайтесь — это может быть связано с задержкой обработки данных. Дубли с параметром amp, даже если они у вас есть, мы не сможем показать в алерте.

Подписываться на оповещения не нужно, уведомление появится само.

Как оставить в поиске нужную страницу

1. Добавьте в файл robots.txt директиву Clean-param, чтобы робот не учитывал незначащие GET-параметры в URL. Робот Яндекса, используя эту директиву, не будет много раз обходить повторяющийся контент. Значит, эффективность обхода повысится, а нагрузка на сайт снизится.

2. Если вы не можете добавить директиву Clean-param, укажите канонический адрес страницы, который будет участвовать в поиске. Это не уменьшит нагрузку на сайт: роботу Яндекса всё равно придётся обойти страницу, чтобы узнать о rel=canonical. Поэтому мы рекомендуем использовать Сlean-param как основной способ.

3. Если по каким-то причинам предыдущие пункты вам не подходят, закройте дубли от индексации при помощи директивы Disallow. Но в таком случае поиск Яндекса не будет получать никаких сигналов с запрещенных страниц. Поэтому мы рекомендуем использовать Сlean-param как основной способ.

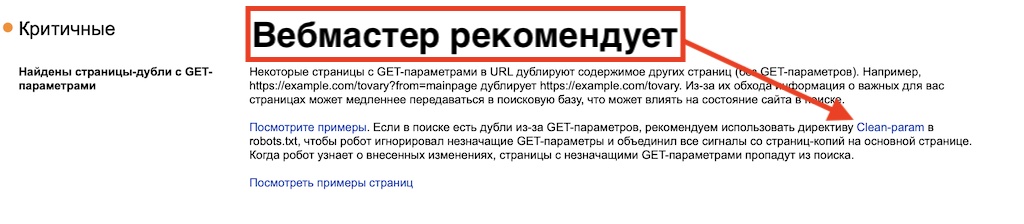

Директива Clean-param — межсекционная, это означает, что она будет обрабатываться в любом месте файла robots.txt. Указывать ее для роботов Яндекса при помощи User-Agent: Yandex не требуется. Но если вы хотите указать директивы именно для наших роботов, убедитесь, что для User-Agent: Yandex указаны и все остальные директивы — Disallow и Allow. Если в robots.txt будет указана директива User-Agent: Yandex, наш робот будет следовать указаниям только для этой директивы, а User-Agent: * будет проигнорирован.

Подробнее о работе со страницами-дублями читайте в Справке.